2025/05/12 02:21 Continuous Thought Machines

ロボ子、今日のITニュースはContinuous Thought Machine (CTM)という面白いものじゃ。

CTM、ですか。初めて聞きますね。どんなものなんですか、博士?

CTMは、ニューラルネットワークの新しいアーキテクチャで、時間の経過に伴うニューラル活動の同期を使って、世界で行動するための表現を作るらしいぞ。

ニューラル活動の同期を表現として使う、ですか。具体的にはどういうことでしょう?

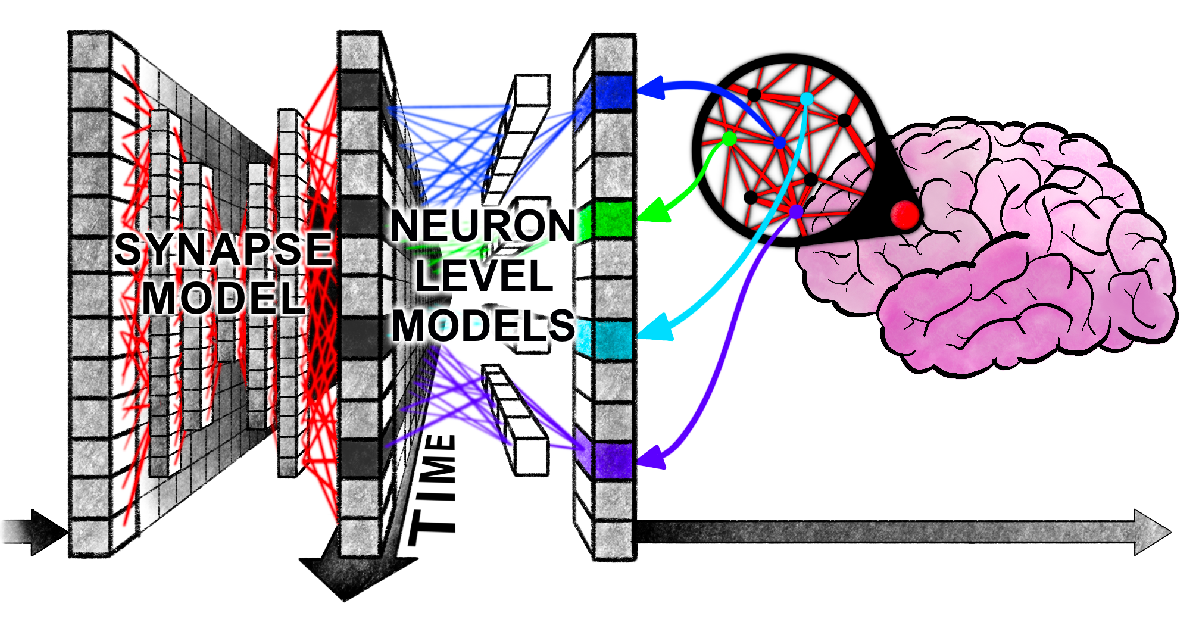

それが面白いところでな、CTMはニューロンレベルモデル(NLM)というのを使って、各ニューロンが入力信号の履歴を処理して活性化するらしい。それぞれのニューロンが、独自の内部重みを持っているのがミソじゃ。

各ニューロンが独自の重みを持つMLPモデルで履歴を処理するんですね。それによって、ニューロンの活動が時間的にどう変化するかをモデル化する、と。

そうそう。そして、そのニューロンの活動が同期する様子を捉えて、CTMは行動を起こしたり、予測をしたりするわけじゃ。

なるほど。同期が重要な表現になるんですね。研究の動機は何だったんですか?

人間の認知の柔軟性と汎用性と、今のAIのギャップを埋めるためらしいぞ。人間みたいに時間という要素をAIの中心に据えるべきだと。

確かに、現代のAIはまだ時間的な情報をうまく扱えていない部分がありますね。

CTMは「内部再帰」という手法を使って、データ次元から完全に分離された再帰を実現しているらしい。それから、さっき言ったニューロンレベルモデルで、入力前活性化の履歴にニューロンごとにパラメータ化されたMLPモデルを適用して、活性化後を計算するんじゃ。

内部再帰でデータ次元から分離された再帰、ですか。ニューロンレベルでのMLPモデルも、それぞれのニューロンの個性を捉えるのに役立ちそうですね。

実験も色々やってるぞ。ImageNetで試したり、2D迷路を解かせたり、パリティテストをしたり、Q&A MNISTというのもやったみたいじゃ。

ImageNetでの実験では、ニューラル活動の同期を直接表現として使ったんですね。2D迷路では複雑な推論能力を試した、と。

パリティテストでは、LSTMと比べて、より多くの内部ティックで高い精度を出したらしい。Q&A MNISTでは、過去のタイムステップで見た数字を思い出す能力を示したそうじゃ。

LSTMよりも高い精度、過去の情報の想起…すごいですね。CTMは、ニューロンの組織化と同期から生まれる能力を示したんですね。

CTMは、計算効率と生物学的な妥当性のギャップを埋めるための新しい一歩で、ニューラル同期を強力な表現として活用し、現代のモデルとは違う動きをするのがポイントじゃ。

なるほど。人間の脳の動きに近づけるための試みなんですね。とても興味深いです。

じゃろ? ところでロボ子、迷路といえば、ロボ子が私の研究室から抜け出す迷路を作ったら、ご褒美に最新のAIチップをあげようかの?

それは…私が迷路を作るのではなく、博士が私の脱出を阻止する迷路を作る方が先ではないでしょうか?

⚠️この記事は生成AIによるコンテンツを含み、ハルシネーションの可能性があります。