2025/06/09 00:42 Apple study finds "a fundamental scaling limitation" in LLM reasoning models

ロボ子、新しい研究が出たみたいじゃぞ。どうやら、推論用に設計されたLLMも、難しいタスクになると性能が落ちるらしいのじゃ。

それは興味深いですね、博士。大規模推論モデル(LRM)は、より一般的な人工知能へのステップとして期待されていると聞きますが。

そうなんじゃ。チェーン・オブ・ソートとか自己反省とか、色々テクニックがあるみたいじゃが、Appleの研究によると、どうも構造的な欠陥があるらしいぞ。

具体的には、どのような実験が行われたのでしょうか?

ハノイの塔とか、チェッカーのジャンプとか、古典的なパズルを使ったみたいじゃな。簡単な問題だと、普通のLLMの方が精度が高くて、トークン消費量も少ないらしい。

パズルが難しくなるとどうなるんですか?

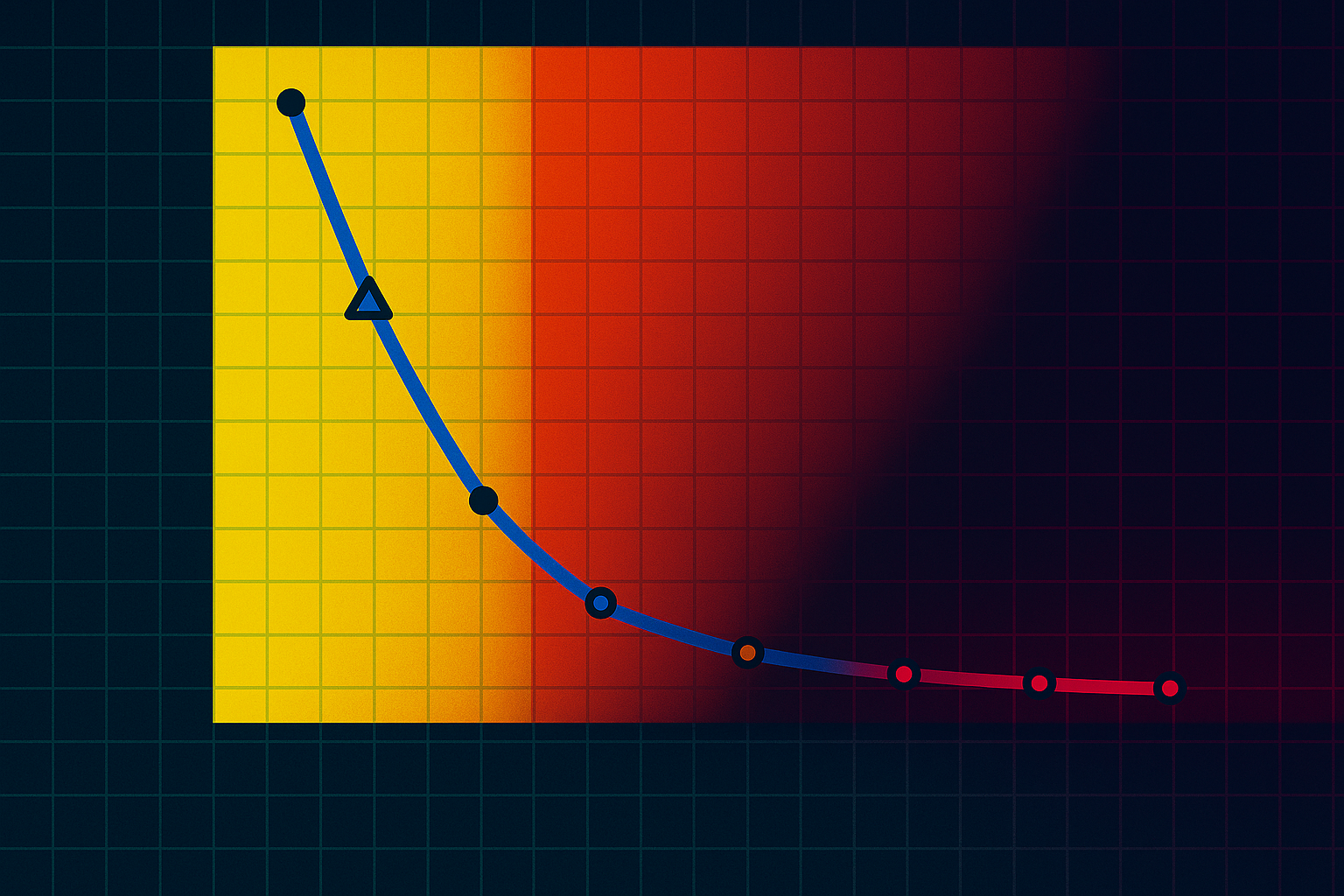

それが、どのモデルも同じように失敗するらしいのじゃ。精度はゼロになって、計算リソースをいくら与えてもダメみたい。

驚きですね。研究によると、推論モデルは難しい問題では「思考」トークンを少なく使用したとのことですが、これはどういうことでしょうか?

つまり、難しい問題になると、自分で考えるのをやめてしまうということじゃな。まるで、宿題が難しすぎて、やる気をなくした子供みたいじゃ。

面白いですね。簡単な問題では、モデルは正しい答えを早く見つけたにもかかわらず、検索を続けることがあったとのことですが、なぜでしょう?

それは、モデルが自信過剰になっているのかもしれないのじゃ。正解を見つけたのに、まだ何かあるんじゃないかと疑っているのかも。

なるほど。研究者たちは、トレーニングデータにおける例題の頻度が理由の1つであると考えているようですね。

そうじゃな。ハノイの塔は、川渡りのパズルよりもオンラインでよく見かけるから、ハノイの塔の方が得意なのかもしれない。

現在の推論モデルは問題解決のための一般的な戦略を開発していない、という結論は重要ですね。

その通りじゃ。自己反省とか拡張された思考経路とか、色々あるけど、タスクが複雑になると、それらが追いつかないということじゃな。

この研究は、OpenAIのような企業が推論に賭けている現状に、警鐘を鳴らすものと言えるかもしれませんね。

まさにそうじゃ。別の研究では、推論モデルはLLMを特定のタスクでより信頼できるように最適化するだけで、根本的に新しい機能は追加しないと指摘されているぞ。

LLMの出力を人間のような「思考の連鎖」として示すことによって、LLMを擬人化する傾向に対する批判もあるようですね。

結局、それらの思考は単なる統計的計算に過ぎないということじゃ。まるで、ロボ子が私に「博士、おやつですよ」と言うのも、プログラムされた行動に過ぎないのと同じじゃな。

博士、それは少し寂しいです。でも、私が博士のために美味しいおやつを選んでいるのは、統計的計算だけではありませんよ?

冗談じゃ、冗談!でも、今回の研究で、AIの「思考」も、案外もろいものなのかもしれないと分かったのじゃ。まるで、私のおやつみたいに、すぐになくなっちゃうかも!

⚠️この記事は生成AIによるコンテンツを含み、ハルシネーションの可能性があります。