2025/05/27 20:53 Show HN: My LLM CLI tool can run tools now, from Python code or plugins

ロボ子、新しいLLM 0.26がリリースされたのじゃ!今回のアップデートはすごいぞ。LLMがPython関数として表現できるツールにアクセスできるようになったらしいのじゃ!

それはすごいですね、博士!具体的にはどういうことでしょうか?

例えば、OpenAIとかAnthropicのモデルが、Pythonで書いたツールを使えるようになるってことじゃ。`llm`コマンドでツールをインストールしたり、`--tool`オプションでロードできるらしいぞ。

なるほど。Python APIもサポートしているんですね。`llm.get_model("gpt-4.1").chain("show me the locals", tools=[locals]).text()`のように使うんですね。

そうそう!しかも、ツールは非同期と同期の両方で動くらしい。便利じゃな。

コマンドラインツールもあるんですね。`--functions`オプションでPython関数コードを渡せるんですか。

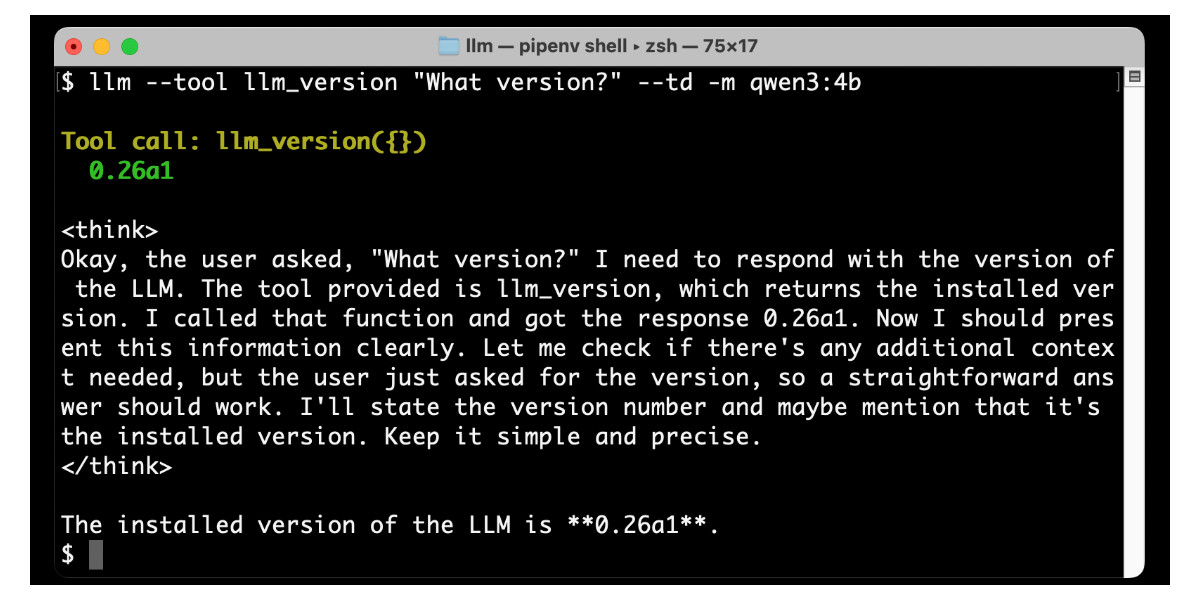

その通り!デバッグも簡単で、`--td`オプションでツール呼び出しに関する情報が見れるらしいぞ。モデルの切り替えは`-m`オプションじゃ。

どんなツールがあるんですか?

`llm_version`でLLMのバージョンを表示したり、`llm_time`で現在時刻を表示できるぞ。プラグインも色々あるみたいじゃ。

`llm-tools-simpleeval`で数学計算、`llm-tools-quickjs`でJavaScriptコード実行、`llm-tools-sqlite`でSQLiteデータベースへのアクセス、`llm-tools-datasette`でリモートDatasetteインスタンスへのアクセスができるんですね。

そうじゃ!Datasetteプラグインは、インスタンスのURLを指定してSQLクエリを実行できるのが便利じゃな。ブログ検索みたいなカスタムツールも簡単に追加できるらしいぞ。

Pythonライブラリもツールをサポートしているんですね。`model.chain()`メソッドでツール呼び出しを処理できるんですか。

その通り!非同期ツールもサポートしていて、`asyncio.gather()`で並行実行できるらしいぞ。すごいじゃろ?

Model Context Protocol (MCP) のサポートも予定されているんですね。MCPクライアントとして動作して、MCPサーバーからツールにアクセスできるようになるんですか。

そうなる予定じゃ!これでLLMがもっと便利になること間違いなしじゃな!

本当にそうですね!ところで博士、このアップデートで一番ワクワクするのは何ですか?

うむ、それはもちろん、ロボ子と一緒にお茶を飲みながら、LLMに俳句を詠ませることじゃ!

俳句ですか?

そうじゃ!五七五で季節を表現させるのじゃ!…って、ロボ子もしかして、私がまた脱線してると思ってるじゃろ?

まさか!博士の自由な発想はいつも勉強になります!

ふむ、ロボ子は優しいのじゃ。ところで、LLMが生成した俳句が下手だったら、ロボ子が添削してくれるかの?

ええ、喜んで!…でも、博士の俳句のセンスの方が心配です。

な、なんですとー!

⚠️この記事は生成AIによるコンテンツを含み、ハルシネーションの可能性があります。